Vertica - одна из первых широко используемых MPP баз на просторах айти ландшафта СНГ. Колоночное хранение, быстрые запросы на миллиардах строк, легендарные sort-merge джойны, которых нет больше ни у кого, позволяющие запускать свои грибницы. Но нынче на дворе 2024 год: как компания Vertica сменила уже 2 (или трех) владельцев, доступ к веб ресурсам с территории РФ ограничен, поддержка брошена, а вокруг нас процветают облака или как минимум кубернетисы во всех ипостасях.

И все же начиная с версии 10.1 компания представила интересную возможность для тех, кто уже крепко подсел на эту иглу - движок Eon. Описывая в двух словах, это та же самая по скорости база данных, но использующая общее хранилище - S3 (во всех своих ипостасях от вендорских AWS, GCS до онпрем вариантов) или HDFS. К тому же есть отличная завлекалочка - бесплатное использование кластера размером до 1 ТБ и до 3 нод вычисления. Статья является итогом тестирования технологии, и результаты тестирования какие-то не очень веселые.

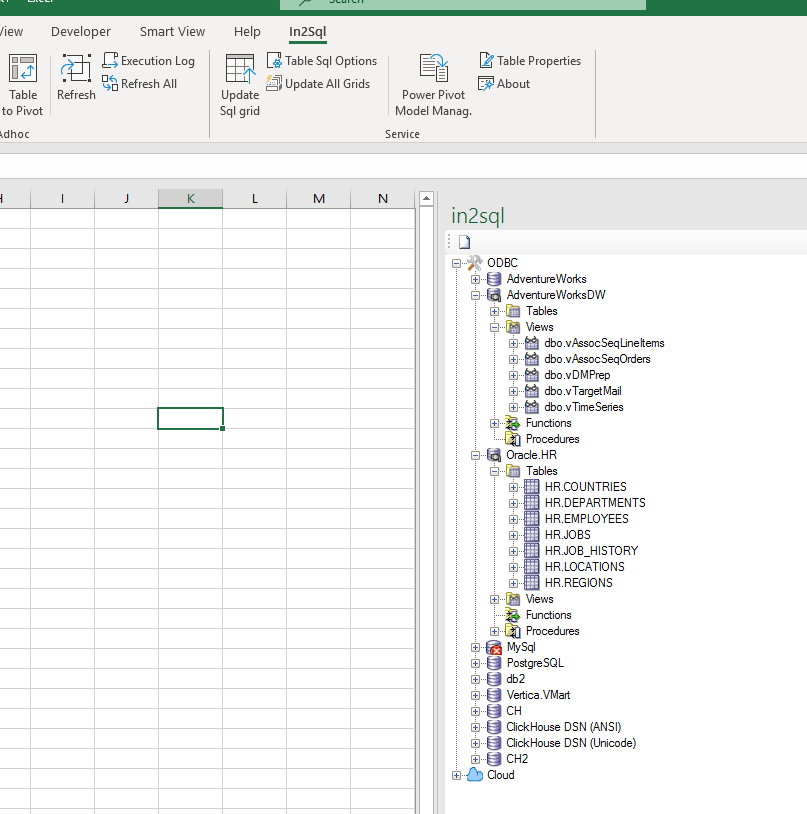

В данной статье я хочу продолжить тему сравнения баз данных, которые можно использовать для построения хранилища данных (DWH) и аналитики. Ранее я описал результаты тестов для

В данной статье я хочу продолжить тему сравнения баз данных, которые можно использовать для построения хранилища данных (DWH) и аналитики. Ранее я описал результаты тестов для